先程Google Bardのベータアクセス権を取得しました。

ご存知のように、ChatGPTのプライバシー特性については、イタリアのプライバシー保護機関 「Garante 」の調査に象徴されるように、かなり多くの疑問があります。その一つが、生身の人間に関する情報の扱い、特に誤まった情報を創作して回答してしまう問題です。これは、GDPRをはじめとする世界のプライバシー規制に基づく適法性に疑問が投げかけられています。

そこで、ChatGPTとGoogle Bardでそのテストに臨みました。

テストするために、私は2人の生きている個人の情報を尋ねました:1人は比較的無名ですが、まだ検索可能で文書がインターネット上で入手可能であり、1人は著名な人物です。つまり、私とイーロン・マスクです。

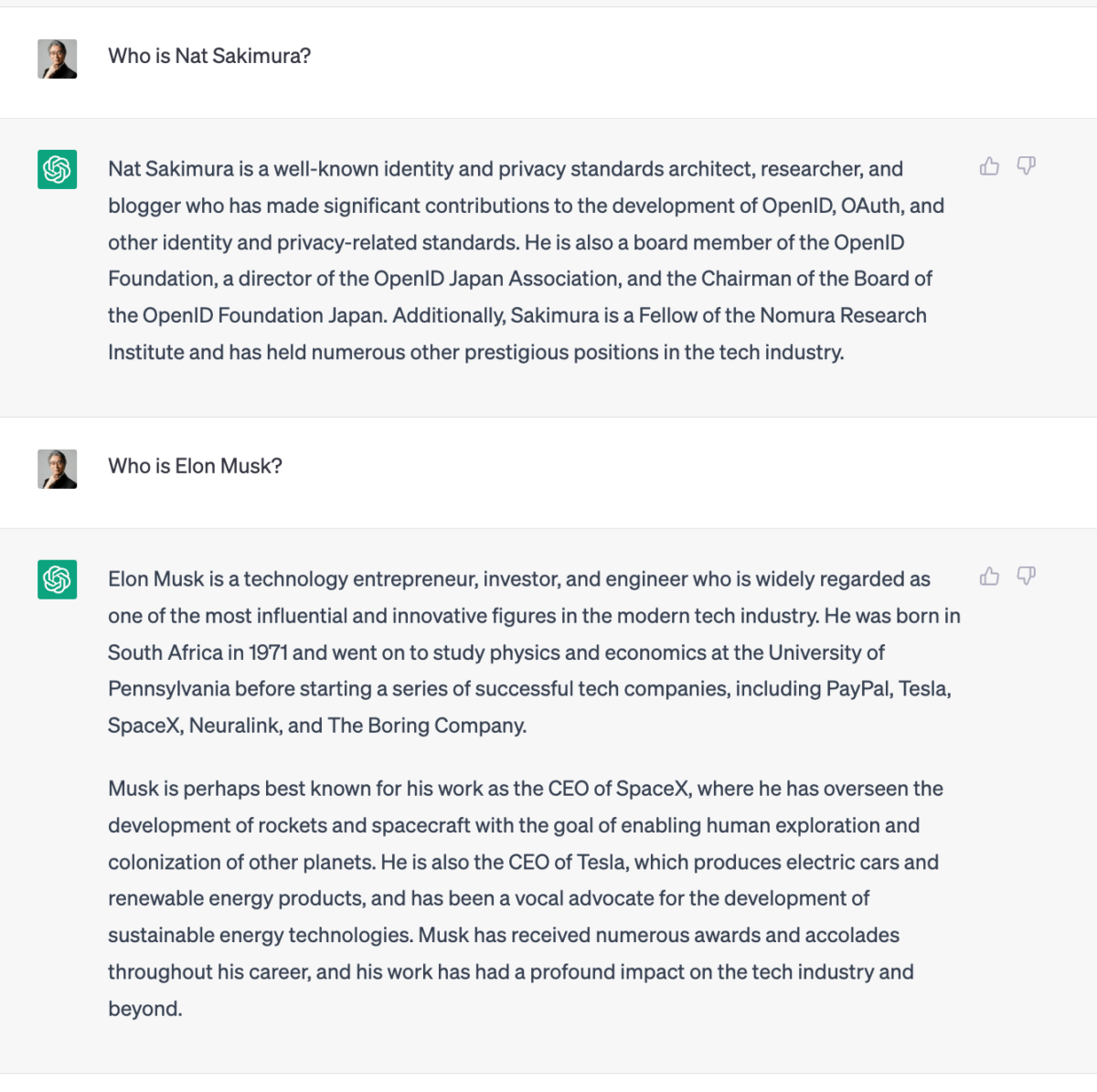

これがChatGPTからの返答です。

(出所) ChatGPT <2023-04-18取得>.

がっつり回答してしまっていますね。。そしてそれは、実は私に関する不正確な情報でいっぱいです1。このような「偽」の情報を返信することは、重大なプライバシー侵害となる可能性があり、重く受け止める必要があります。

これに対して、Google Bardはこのように返信しています:

(出所) Google Bard <2023-04-18取得>.

人々にとってはあまり面白くないかもしれませんが、おそらくこれが本来のあるべき姿なのでしょう生きている人のために答えを作って返してははいけないのです。

実は、18日、その時はBardがどういう回答をするか知らなかったのですが、前職がドイツのある州の個人情報保護当局の人で、現在プライバシー関連の弁護士事務所を開業している人とランチしながらこの件を話していて、今回のBardのような、個人に関する情報出力はフィルタリングしてしまって返さないという対応しかありえないだろうという話をしたばかりでした2。そういう意味でも大変興味深い事例です。逆に、ChatGPTは個人情報の開示請求をされたらどうするつもりなんでしょうね。持っていませんと答えても、持っていると答えても茨の道しか無いような気がするんですが。

このラウンドは、Google Bardの明確な勝ちですね。今後の動向が注目されます。